Todos nos sorprendemos año tras año con lo que Google es capaz de lograr en materia de fotografía computacional. Una prueba de ello son sus dispositivos móviles Pixel con sus increíbles cámaras que han asombrado y continúan maravillando a todos son sus excelentes resultados. Si bien eran reservados en la cantidad de sensores, cuando deciden apostar por incluir más, se aseguran de llegar a unos estándares de calidad bastante altos.La primera apuesta de la compañía para un sistema multicámara en sus dispositivos llegó de la mano del Pixel 3 en 2018. Una decisión como casi siempre alejada de las tendencias del momento; ya que en lugar de ubicar ese segundo sensor ultra gran angular en la parte trasera, pasaba al frontal para ofrecer “super selfies”.

Ya otros fabricantes habían optado mucho antes por incluir lentes ultra gran angular para complementar más la cámara de sus dispositivos; el problema de estos es que provocan una distorsión natural de la imagen en este tipo de fotografía. La solución como siempre llegó de la mano del software por parte de Google, acabando con esa problemática desde el primer momento.

Así es como es como Google corrige la distorsión provocada por un gran angular

Con la llegada del Pixel 6 se volvió a demostrar la importancia de la inteligencia artificial en la fotografía; específicamente como esta podía acabar con las distorsiones de perspectiva, algo que ya tenían solventado desde hace 3 años. Los selfies del Pixel 3 abarcan mayor campo de visión lo que permite capturar más información y hacer fotos grupales sin dejar a nadie fuera.

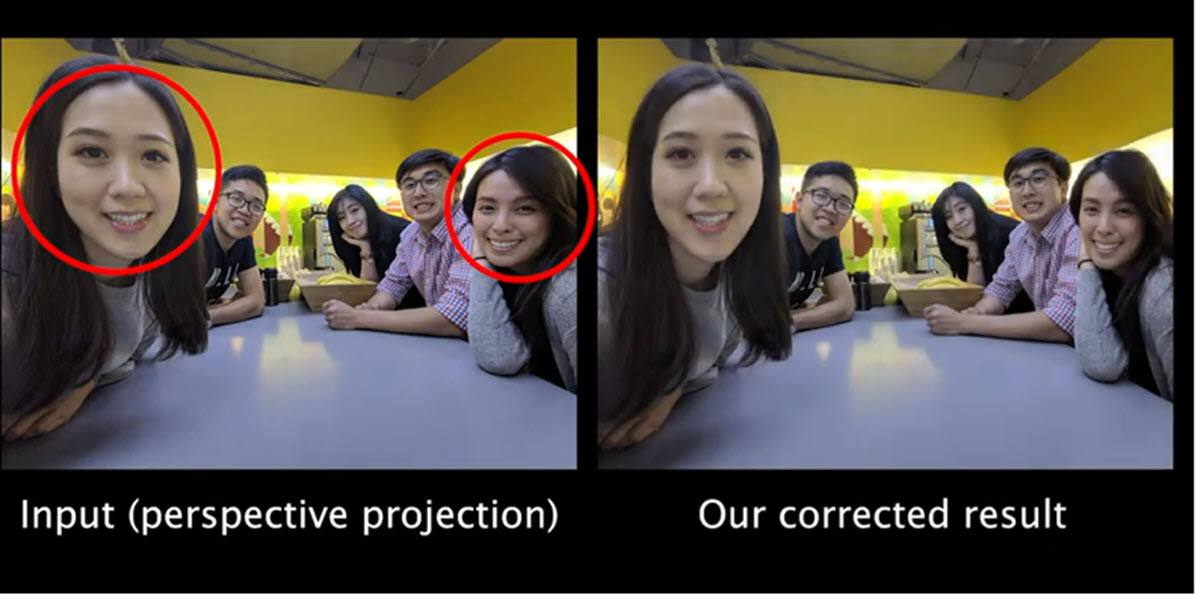

Pero como cualquier otra cámara gran angular, esta generaba unas imperfecciones en la imagen especialmente evidente en los rostros de las personas. Los ingenieros YiChang Shih, Wei-Sheng Lai y Chia-Kai Liang fueron los encargados de idear un algoritmo que eliminara este inconveniente de manera eficaz; mientras que para la mayoría de fabricantes esto sigue siendo un verdadero desafío ya que ofrecen soluciones poco prácticas e introducen artefactos en la fotografía.

Google trabaja esto segmentando los diferentes elementos de la foto al proyectar una “malla de distorsión sensible al contenido”; esto aplica correcciones a partes específicas de la imagen de modo que es posible realizar una transición bastante precisa entre los diferentes planos. Según sus investigadores esta técnica es efectiva en campos de visión de entre 70º y 120º incluso con un grupo numeroso de personas en la fotografía.

Todo este proceso se realiza de forma automática en menos de 1 segundo y tampoco requiere de un hardware demasiado potente. Aclaran que su eficiencia es óptima en el uso tanto de CPU, de GPU como de memoria, pudiendo trabajar con sensores de hasta 16 megapíxeles. Otro de los trucos ocultos en el posprocesado de los Pixel que le aporta esa magia única a sus instantáneas.